Managed Kubernetes

Orchestrarea de containere orientată spre viitor

Containerele în IT - cei mai cunoscuți reprezentanți sunt containerele Kubernetes ale platformei open source Google. Acestea oferă o soluție la o problemă prea des întâlnită în operațiunile IT: rularea software-ului în mod fiabil și standardizat - indiferent de ținta de implementare. Înainte de containere, mașinile virtuale (VM) erau principala metodă utilizată pentru a rula mai multe aplicații izolate pe un singur server. VM-urile necesită o gazdă hipervizor care abstractizează resursele.

Gestionați containerele gratuit timp de 30 de zile!

Cu toate acestea, containerele nu au nevoie de un sistem de operare propriu. Motorul de containere asigură accesul la nucleul sistemului de operare gazdă (OS gazdă). Microserviciile independente sunt puse la dispoziție în containere. Fiecare serviciu individual poate fi configurat, implementat, scalat și reînnoit separat. Prin urmare, containerele sunt necesare de urgență pentru transformarea digitală și sunt mai rapide, mai portabile și mai ușor de actualizat decât VM-urile.

Care sunt avantajele utilizării containerelor?

-

Viteză: Spre deosebire de mașinile virtuale, care de obicei durează câteva minute pentru a porni, containerele nu trebuie să aștepte pornirea sistemului de operare și pornesc în câteva secunde.

-

DevOps: Viteza, amprenta redusă și eficiența resurselor fac din containere un instrument ideal pentru utilizarea în mediile de dezvoltare automatizate și permit optimizarea canalului CI/CD.

-

Disponibilitate: Containerele împachetează doar aplicația și dependențele sale. Acest lucru permite operarea ușoară pe o mare varietate de platforme.

-

Scalabilitate: Containerele sunt, de obicei, de dimensiuni reduse, deoarece nu necesită un sistem de operare separat, cum ar fi mașinile virtuale, și, astfel, se pot extinde în mod arbitrar.

-

Consecvență: Deoarece containerele conțin toate dependențele și configurațiile la nivel intern, ele asigură faptul că dezvoltatorii pot lucra într-un mediu coerent, indiferent de locul în care sunt implementate containerele.

Oferta open source Kubernetes de la Google

Ce sunt K8-urile? Infrastructura Kubernetes explicată simplu

Kubernetes (abrevierea k8s) este un software de orchestrare. Acesta permite dezvoltatorilor de software și administratorilor IT să organizeze, să gestioneze, să monitorizeze și să automatizeze implementarea, scalarea, operarea și administrarea mediilor de containere. Acest mediu de gestionare coordonează infrastructura informatică, de rețea și de stocare. Totul se întâmplă în numele sarcinilor de lucru ale utilizatorilor.

K8s este, de asemenea, o platformă open source portabilă și extensibilă și are un ecosistem mare, în creștere rapidă. Serviciile, asistența și instrumentele Kubernetes sunt disponibile pe scară largă. Pot fi utilizate diverse infrastructuri IT, de exemplu, hostere locale, AWS sau Azure. În 2014, Google a pus proiectul Kubernetes la dispoziția tuturor în mod gratuit, după ce gigantul tehnologic a acumulat peste un deceniu de experiență în rularea de sarcini de lucru în producție la scară largă. Astfel, gestionarea clusterului de containere devine o necesitate, în special pentru proiectele mai complexe, cu un număr mare de containere distribuite pe mai multe servere sau mașini virtuale.

Perspective pentru arhitectura Google Kubernetes

Poduri: Podurile sunt cea mai mică unitate care poate fi implementată în Kubernetes. Acestea încapsulează unul sau mai multe containere, un pod găzduind de obicei un container. O aplicație sau un microserviciu rulează în acest container. Cu toate acestea, atunci când podurile conțin mai multe containere, se întâmplă adesea pentru că containerele trebuie să acceseze aceleași resurse. Acestea împart atunci gazda, spațiul de stocare și rețeaua din cadrul podului.

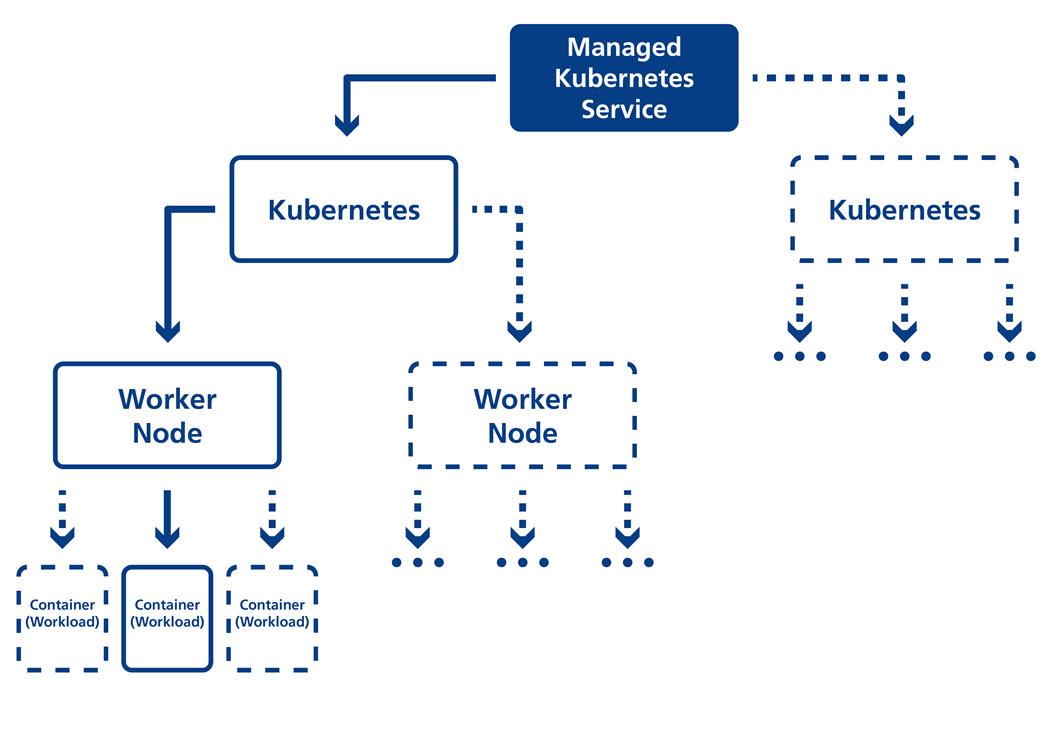

Nod și cluster: Podurile rulează pe noduri, adică pe mașini virtuale sau fizice, care la rândul lor sunt grupate în clustere. Fiecare nod dispune de serviciile necesare pentru rularea podurilor. Un cluster are unități de control numite Kubernetes Masters, care sunt responsabile de gestionarea nodurilor.

Proiectul Borg și povestea Kubernetes:

Sarcini de lucru containerizate nu au existat doar ieri. Google le folosește în producția internă de mai bine de un deceniu. Fie că este vorba de sarcini de servicii precum front-end-urile web, de sisteme de infrastructură precum Bigtable sau de cadre de lucru pe loturi precum MapReduce, Google utilizează în mare parte tehnologia containerelor. Centrul central al proiectelor interne ale Google: Borg. Acest proiect Borg a fost un sistem de gestionare a clusterelor chiar de la Google. Astăzi știm: Kubernetes se întoarce direct la Borg. Și: mulți dintre dezvoltatorii Google care lucrează astăzi la Kubernetes au fost implicați anterior în Borg. Patru funcții centrale ale Kubernetes au apărut din acest proiect: Pods, Servicii, Etichete și IP-per-Pods. Lansarea funcționalităților Cluster Manager nu numai că a dat naștere unor proiecte open source în cadrul Kubernetes, dar și unor servicii găzduite disponibile publicului prin intermediul Google Container Engine. Astfel, Google redă Kubernetes comunității "CNCF" și, în același timp, dorește să facă să avanseze tehnologia containerelor cu ajutorul inteligenței swarm.

Kubernetes administrat prin Medialine

De ce nu este suficient Kubernetes de la Google?

Deși Kubernetes simplifică gestionarea unui peisaj mai mare de containere și calculatoare, utilizarea cu succes necesită cunoștințe aprofundate despre tehnologiile Kubernetes. Implementarea și întreținerea, actualizarea permanentă și monitorizarea sunt adesea foarte consumatoare de timp și complexe.

Cu un mediu de gestionare centrat pe containere, cum este cel al Medialine, infrastructura de calcul, de rețea și de stocare este coordonată într-un mod simplificat. Acest lucru oferă o mare parte din simplitatea platformei ca serviciu (PaaS) cuplată cu flexibilitatea infrastructurii ca serviciu (IaaS). Pentru a opera Kubernetes în mod productiv și eficient, este imperativ un management competent.

Cum să vă gestionați containerele

Cu Managed Kubernetes pe VMware Tanzu, Medialine permite o configurare complet automatizată a clusterelor Kubernetes - cu tehnologia de clasă enterprise a VMware Tanzu. De exemplu, mai multe clustere pentru mediile de testare pot fi configurate cu ușurință și în cel mai scurt timp posibil și pot fi șterse din nou, dacă este necesar. Vă oferim o configurare Kubernetes cât mai simplă și compatibilă cu configurația individuală pentru mediul dumneavoastră de producție.

Sarcini de lucru de înaltă performanță prin auto-scalare

Structură de platformă uniformă și eficientă pentru containere și mașini virtuale cu configurare individuală și plug-in-uri opționale

Integrated Persistent Storage auf hochverfügbarer und skalierbarer Plattform

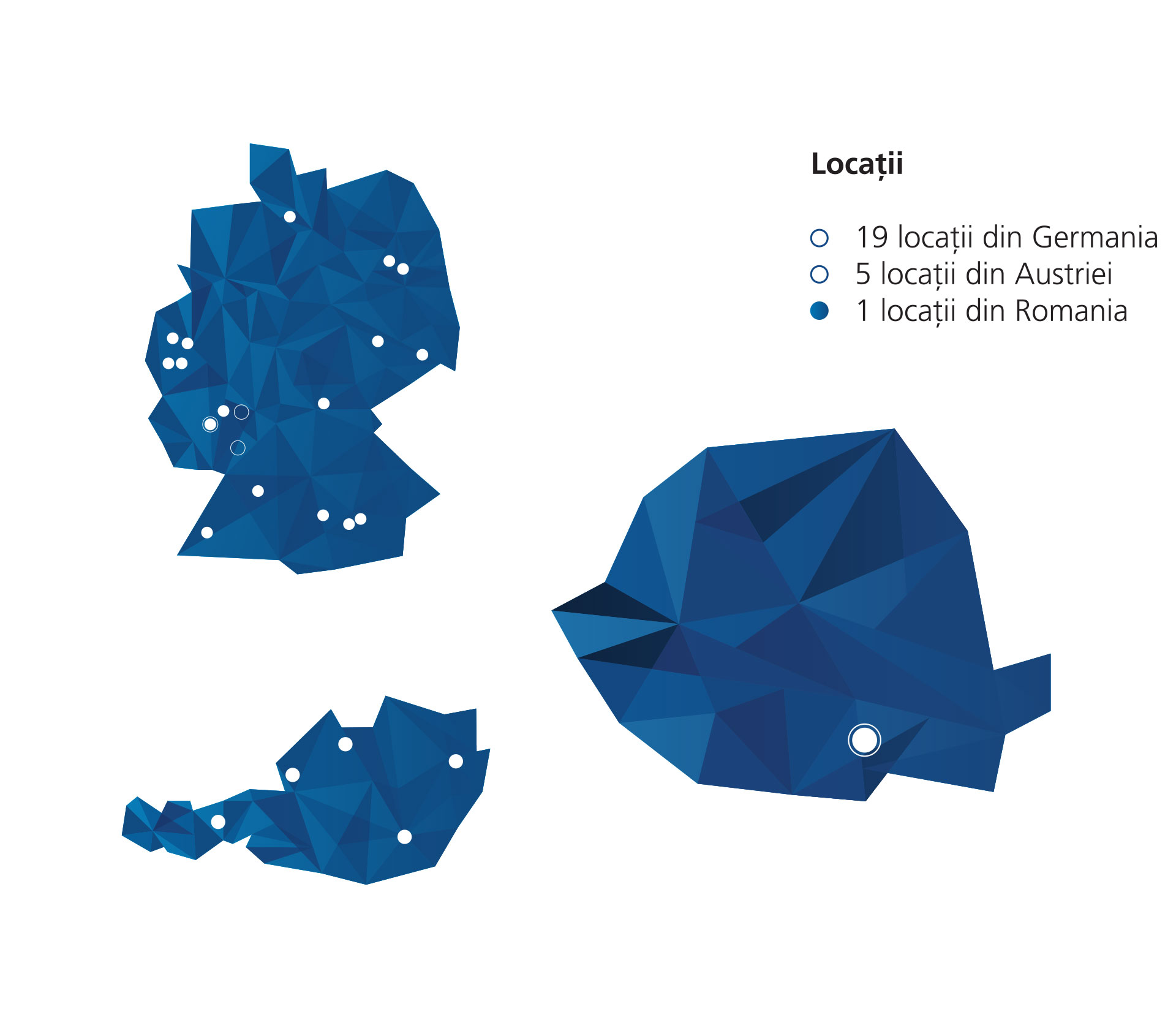

Centrul de date german și protecția datelor EU-DSGVO

La cerere, configurarea unui centru de date geo-redundant în mai multe locații.

Ajutor pentru echipele DevOps

Flexibil și personalizat

Asistență cu persoane de contact dedicate

Punctul nostru unic: CompanyCloud

Serviciul Kubernetes gestionat poate fi gestionat cu ușurință prin intermediul portalului de autoservire CompanyCloud. În plus, sistemele proprii pot fi integrate cu ușurință cu aplicațiile SaaS din CompanyCloud.

Noi construim pentru dvs. puntea dintre infrastructurile VMware tradiționale și sarcinile de lucru containerizate. Pentru că oferim un adevărat multi-tenancy prin intermediul unor tehnologii de top, ceea ce înseamnă că puteți integra și vizualiza în mod inteligent resursele pe care le găzduiți în CompanyCloud, împreună cu dumneavoastră onPrem sau cu un hyperscaler în structura noastră Kubernetes. Nu numai că primiți un cluster Kubernetes independent și dedicat în loc de o structură de cluster partajat, dar puteți vizualiza și configura toate clusterele Kubernetes, resursele consumate, memoria și stocarea în portalul de autoservire. CPU per nod, tipul de CPU, RAM per nod, dimensiunea de stocare per nod, tipul de stocare și clasa de performanță a stocării pot fi selectate în mod liber pentru workers și masters - acest lucru înseamnă că puteți adapta toate proprietățile clusterului Kubernetes la nevoile dvs.

Monitorizare Kubernetes și găzduire Kubernetes cu VMware Tanzu

Tanzu este un produs al familiei VMware și se integrează perfect în întregul ecosistem al liderului de segment. Integrarea încrucișată și adaptarea atât din partea echipei, cât și din partea clientului nu reprezintă o problemă și, prin urmare, un mare avantaj. Acest lucru înseamnă că infrastructurile clasice VMware pot fi utilizate în continuare. Experții noștri de la Medialine utilizează Tanzu Kubernetes Grid și Container Service Extension (CSE). Special conceput pentru multicloud-ul nostru, oferim produsul Managed Kubernetes pe VMware Cloud Director cu multi-tenancy ca bază, ca un Kubernetes as a Service open source.

Tanzu cuprinde un întreg portofoliu de produse și servicii, unele dezvoltate chiar de VMware, iar altele achiziționate. Cu ajutorul acestora, companiile își pot controla singure aplicațiile, de la dezvoltare (Build), la gestionare (Manage) și până la operare (Run).

Tanzu oferă:

-

Consolidarea, standardizarea și optimizarea containerelor și a mașinilor virtuale.

-

Modernizarea aplicațiilor tradiționale

-

Dezvoltarea de software de calitate superioară

-

Cicluri de lansare mai rapide prin procese accelerate

Produsul este deosebit de interesant pentru toți cei pentru care lucrul cu Kubernetes face parte din activitatea lor zilnică. Oriunde au loc dezvoltări și produsele software sunt concepute de către dezvoltatorii interni, Tanzu va contribui la simplificarea și optimizarea fluxurilor de lucru. Companiile de dimensiuni medii care doresc să își degreveze dezvoltatorii de partea de dezvoltare a infrastructurii ar trebui să se bazeze pe containerele Kubernetes.

ÎNTREBĂRI ȘI RĂSPUNSURI

Virtualizarea are loc astfel fără un hipervizor. Mai multe containere izolate unele de altele pot fi exploatate în cadrul unei instalații de sistem de operare. Containerele conțin atât componentele necesare sistemului de operare, cât și aplicațiile. În containere sunt puse la dispoziție microservicii independente și executabile individual. Fiecare serviciu individual poate fi configurat, implementat, scalat și reînnoit separat.

Containerele pot fi furnizate, pornite și oprite foarte rapid. În cazul în care este nevoie de mai multă capacitate pentru un serviciu, sunt puse la dispoziție noi containere. În schimb, containerele pot fi șterse imediat când nu mai sunt necesare.

Furnizarea, scalarea, echilibrarea încărcăturii și conectarea în rețea a containerelor este complexă și consumatoare de timp. Orchestrarea containerelor automatizează aceste procese și oferă, de asemenea, numeroase opțiuni pentru conectarea altor interfețe și funcții centrale.

Kubernetes (abrevierea K8s) este un software de orchestrație open source oferit de Google începând cu 2014. Acesta permite dezvoltatorilor de software și administratorilor IT să organizeze, să gestioneze, să monitorizeze și să automatizeze implementarea, scalarea, operarea și administrarea mediilor de containere.

Aceasta înseamnă că dezvoltatorii trebuie să se ocupe doar de aplicațiile propriu-zise, care rulează în noduri. Acest lucru permite economisirea costurilor și a resurselor interne - ceea ce facilitează concentrarea pe activitatea de bază.

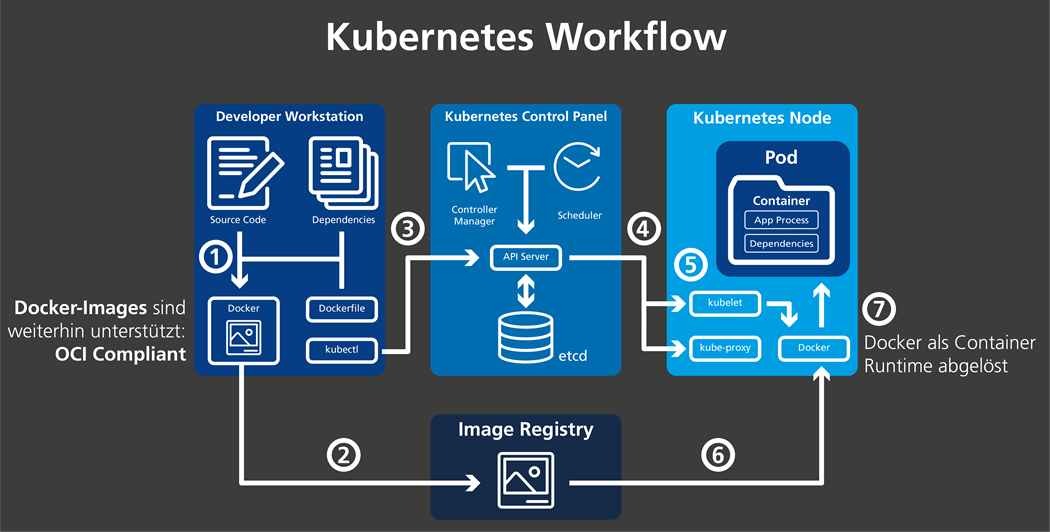

Docker este o întreagă stivă tehnologică, din care doar o parte este "containerd". Această parte întruchipează propriul său timp de execuție de nivel înalt pentru containere. În ceea ce privește clusterele Kubernetes, Docker este utilizat pentru a prelua și a rula imagini de containere folosind timpul de execuție al containerelor. Docker este o alegere populară pentru acest runtime (alte opțiuni comune sunt containerd și CRI-O). Cu toate acestea, Docker nu a fost conceput pentru a fi încorporat în Kubernetes. Acest lucru duce la probleme.

Containerele sunt împachetate în așa-numitele imagini Docker și sunt menținute și accesibile într-un registru de imagini, cum ar fi Harbor. Nodurile Kubernetes conțin, la rândul lor, un motor de containere (runtime) pentru a executa containerele (a se vedea figura).

Docker nu mai poate fi utilizat ca runtime (motor) de containere în Kubernetes de la sfârșitul anului 2020, deoarece ultima actualizare a Kubernetes a exclus acest lucru. Prin urmare, serviciile Managed Kubernetes, cum ar fi GKE, EKS sau AKS, nu vor mai funcționa pentru nodurile de lucru în viitor. Așadar, dacă serviciul dvs. include personalizări pentru nodurile dvs., este posibil să fie necesar să le actualizați în funcție de cerințele mediului dvs. și de timpul de execuție.

Categoric da. Kubernetes a dat undă verde pe blogul său. Imaginile Docker sunt în continuare acceptate, deoarece sunt compatibile cu OCI (OCI = Open Container Initiative), adică sunt conforme cu OCI. Acest lucru înseamnă că imaginile Docker pot fi în continuare operate în Kubernetes. Motivul pentru acest lucru este următorul: Imaginea pe care Docker o creează nu este direct o imagine specifică Docker, ci o imagine OCI. Și fiecare imagine conformă cu OCI, indiferent de instrumentul utilizat pentru a o crea, arată la fel pentru Kubernetes. Atât containerd (adică parte din Docker), cât și CRI-O pot prelua și rula aceste imagini.

Imagini Docker

Formular de contact

Sunteți interesat de oferta noastră Managed Kubernetes? Vă rugăm să ne contactați prin intermediul formularului de contact.

Aici puteți vizualiza politica noastră privind protecția datelor.

Downloads

[ Error ]